Qwen3-Embedding介绍

Qwen3-Embedding是一种先进的嵌入式模型,广泛应用于企业级RAG(检索增强型生成)系统中。该模型能够将文本转化为高维向量,为知识库检索和其他AI任务提供强大的支持。为了更好地理解和使用Qwen3-Embedding,以下是几个重要的资源和使用指南。

模型资源链接

Qwen3-Embedding模型的资源非常丰富,以下是几个推荐的平台:

- 硅基流动:硅基流动平台提供了Qwen3-Embedding的最新版本和相关文档,用户可以在 cloud.siliconflow.cn 找到模型资源。

- 魔搭社区:魔搭社区专注于AI模型的共享与开发,用户可以通过 modelscope.cn 搜索并下载Qwen3-Embedding。

- HuggingFace:作为全球领先的AI模型共享平台,HuggingFace上也提供了Qwen3-Embedding的多个版本,访问链接为 huggingface.co。

访问模型资源并使用

通过以上链接,用户可以轻松获取Qwen3-Embedding的最新版本和相关文档。以下为使用模型资源的一些步骤:

- 选择合适的平台,根据需求下载模型。例如,在硅基流动可以快速找到适配企业级需求的模型版本。

- 阅读相关文档,了解模型的参数、使用场景以及集成方式。

- 根据平台的要求,完成模型的安装和配置,确保其能够正常运行。

这些资源不仅能够帮助用户快速入门,还能为后续的企业应用提供技术支持。

模型特性和场景展示

Qwen3-Embedding模型以其高效的嵌入能力和稳定的性能被广泛应用于知识库构建、语义搜索等场景。以下是一些典型的应用场景:

- 用于文本向量化,实现高效的语义搜索。

- 支持多语言嵌入,为全球化企业应用提供便利。

- 与其他AI工具结合,增强企业级RAG系统的检索效率。

图中展示了Qwen3-Embedding模型的关键特性,包括文本向量化过程和语义搜索的应用效果。这些特性为企业级知识库的构建带来了巨大的技术突破。

Ollama安装下载

Ollama是一款功能强大的工具,支持本地部署和运行AI模型。为了帮助用户顺利安装和配置Ollama,以下详细介绍了安装路径设置、安装命令的使用、模型下载目录的修改以及Node.js的安装和报错问题解决。

手动创建安装目录

在安装Ollama之前,建议用户手动创建一个专门的安装目录,以便后续管理文件和运行命令。以下是创建安装目录的步骤:

- 选择一个合适的硬盘位置(例如:

E:\S_Software\Ollama)。 - 在目标位置手动创建一个名为“Ollama”的文件夹,确保文件夹路径清晰且易于记忆。

- 下载Ollama安装包,将安装包(

OllamaSetup.exe)放置在刚刚创建的文件夹中。

这一步骤为后续的安装过程提供了良好的基础,并确保安装路径的规范性。

运行安装命令

在创建好安装目录后,可以开始运行安装命令。以下是具体操作步骤:

- 打开命令行工具(如Windows的cmd),进入安装目录:

cd E:\S_Software\Ollama。 - 运行安装命令:

OllamaSetup.exe /DIR=E:\S_Software\Ollama。其中,/DIR参数用于指定安装路径。 - 按回车键确认命令执行,Ollama将自动开始安装。在安装过程中,请确保路径与之前的创建目录一致。

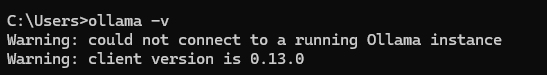

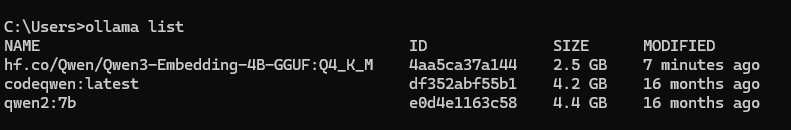

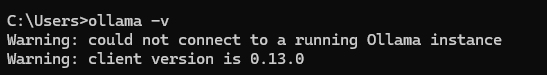

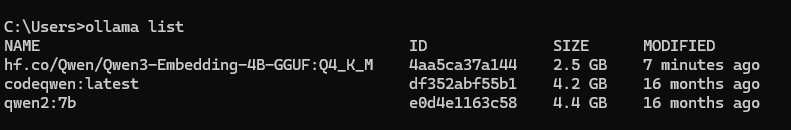

安装完成后,可以通过在命令行输入ollama来检查安装是否成功。如果能显示Ollama的版本号,则说明安装顺利。

修改模型下载目录

为了优化模型管理,用户可以修改默认的模型下载目录。以下是具体步骤:

- 在安装目录中创建一个新的文件夹命名为“models”(例如:

E:\S_Software\Ollama\models)。 - 打开Ollama软件,进入设置界面,找到“Model location”选项。

- 将路径修改为新创建的“models”文件夹路径,例如:

E:\S_Software\Ollama\models。 - 如果之前已有模型文件,可以通过剪切操作将其从默认路径转移到新路径中,并删除旧的文件夹。

通过以上步骤,可以更加方便地管理模型文件,同时避免占用系统盘空间。

安装Node.js及解决报错问题

Ollama的运行可能需要Node.js的支持,特别是在安装n8n时。以下是Node.js安装和常见报错解决方案:

- 安装Node.js:访问Node.js官网(nodejs.cn),下载推荐版本(建议v22以上)。安装过程中可以选择默认设置。

- 解决Windows报错:如果出现

gyp ERR! find VS错误,需要安装Visual Studio的C++桌面开发工具,并勾选Windows SDK。 - 解决Linux/macOS报错:如果提示

distutils缺失,可以安装Python 3.x并确保distutils工具可用。

安装完毕后,可以通过命令行输入npm install -g n8n完成n8n的安装过程。遇到问题时,建议参考相关文档或社区支持。

Qwen3-Embedding本地模型下载及配置

Qwen3-Embedding是一款高效的嵌入模型,支持本地部署和使用。为了充分利用其功能,用户可以通过两种方式下载模型,并完成嵌入模型的创建及测试。以下是详细说明。

两种模型下载方式

获取Qwen3-Embedding模型的方式灵活,用户可以根据需求选择适合自己的下载方式:

- 方式一:HuggingFace下载

HuggingFace是一个全球知名的AI模型共享平台。用户可以访问 HuggingFace 下载量化后的GGUF格式模型,例如:

Qwen3-Embedding-4B-Q4_K_M.gguf。下载完成后,需通过Ollama创建嵌入模型,具体步骤请见下文。

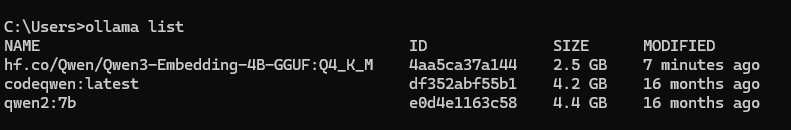

- 方式二:通过Ollama命令直接下载

Ollama提供了便捷的命令行下载方式。运行以下命令即可直接下载模型:

ollama run hf.co/Qwen/Qwen3-Embedding-4B-GGUF:Q4_K_M这种方式简化了下载流程,并自动将模型集成到本地环境中。

创建嵌入模型并进行测试

下载模型后,需要通过Ollama创建嵌入模型。以下是详细步骤:

- 创建一个最简的模型文件(Modelfile):

echo FROM E:\Ollama\Qwen3-Embedding-4B-Q4_K_M.gguf > Modelfile这里的路径为之前下载的模型文件所在位置。

- 运行创建命令:

ollama create qwen3_embedding -f Modelfile此命令将使用指定的模型文件创建一个嵌入模型,命名为

qwen3_embedding。 - 测试嵌入模型:

通过命令行输入以下命令进行测试:

curl http://localhost:11434/api/embed -d "{\"model\":\"qwen3_embedding\",\"input\":\"Hello\"}"如果返回向量化的数据,则说明模型创建成功并可正常使用。

通过curl命令测试模型效果

使用curl命令是验证嵌入模型功能的重要方式。以下是具体步骤:

- 运行curl命令,测试模型是否能够对输入文本进行向量化处理。

- 确保curl请求中的

model名称与创建的嵌入模型名称一致。 - 测试示例:

curl http://localhost:11434/api/embed -d "{\"model\":\"qwen3_embedding\",\"input\":\"Hello World\"}"此命令将输出一组向量化结果,用于后续的语义搜索和知识库检索。

通过以上步骤,用户可以成功创建并测试Qwen3-Embedding嵌入模型,为知识库应用打下坚实的基础。

n8n创建RAG工作流

n8n是一款强大的自动化工作流工具,可用于创建复杂的RAG(检索增强型生成)系统工作流。在本章节中,我们将详细介绍如何通过n8n实现一个RAG工作流,包括触发方式选择、文件读取组件的添加、循环组件的配置、向量数据库的创建以及嵌入模型和文档解析模型的配置。

选择触发方式

要开始创建工作流,首先需要选择一个触发方式。n8n提供多种触发选项,适合不同场景。为了简单起见,我们选择“手动触发”(Trigger manually)。

- 在n8n的界面中,添加一个新节点,选择“Trigger manually”。

- 这种触发方式允许用户手动启动工作流,适合开发和调试阶段。

此触发方式提供了灵活性,确保工作流在用户准备好时才运行。

添加文件读取组件并测试通过

在RAG系统中,知识库文件的读取是关键的一步。n8n提供了一个“Read/Write Files from Disk”组件来完成此任务。

- 添加一个“File”节点,选择“Read”作为操作类型。

- 在“File Path”字段中输入文件夹路径,例如:

E:\F_File\RAG\**,表示读取该路径下的所有文件。 - 点击“Test”按钮,确保文件读取功能正常。如果提示测试成功,则表示配置无误。

这一组件使得工作流能够访问本地存储的知识库文件,为后续的处理提供数据支持。

加入循环组件实现文件夹内容的循环读取

为了能够动态处理文件夹中的内容,可以使用n8n的“Loop over Items”循环组件。

- 添加一个“Loop over Items”节点,将其连接到文件读取组件的输出。

- 在“Batch Size”字段中设置每次循环处理的文件数量,例如设置为1以逐个处理文件。

- 通过测试运行工作流,确保循环能够正确读取文件夹内的所有文件。

该步骤实现了动态处理文件夹内容的功能,让工作流对新增文件具有扩展性。

向量数据库的创建和文档转化为向量

向量数据库是RAG系统的核心部分,用于存储知识库文档的嵌入向量。以下是创建过程:

- 添加一个“Vector Store”节点,选择“Simple Vector Store”作为数据库类型。

- 在“Add Documents to Vector Store”步骤中,将读取的文档转化为嵌入向量。

- 配置“Memory Key”,确保文档的嵌入数据能够正确存储。

通过这一步骤,工作流能够高效存储和检索知识库的嵌入向量,提升系统性能。

Embedding模型和Document解析模型的配置

为了完成向量化过程,需要配置嵌入模型和文档解析模型:

- Embedding模型配置:

选择本地部署的嵌入模型,例如通过Ollama创建的模型。确保连接地址正确(

localhost或127.0.0.1)。 - Document解析模型配置:

选择“Default Data Loader”节点,并设置文档解析方式。

- “Type of Data”选择二进制(Binary)。

- “Text Splitting”选择自定义(Custom)以实现更精准的语义分割。

配置完成后,工作流即可实现文档的语义分割和向量化处理,最终提高检索效率。

测试知识库的准确性

在一个企业级的RAG(检索增强型生成)系统中,知识库的准确性至关重要。通过系统的对话测试,我们可以验证知识库的检索能力,并发现潜在的优化点。以下将详细阐述测试的过程、优化策略以及不同工具的问答能力对比。

通过对话测试知识库的检索能力

测试知识库的检索能力是评估系统性能的重要步骤。在实际测试中,我们通过模拟用户对话来观察系统如何响应检索请求。

- 启动工作流后,通过对话界面输入问题,例如:

"找一下iOS禁止系统更新的网址"。 - 系统根据嵌入模型和向量数据库的配置,从知识库中提取相关信息,并以结构化形式返回答案。

- 在测试过程中,我们重点关注答案的准确性和与用户问题的相关性,以及响应时间是否符合预期。

测试结果表明,当系统使用本地知识库时,它能够提供精确的答案,并避免冗余信息。这反映了嵌入模型和向量数据库的高效协同工作。

优化分段式内容的检索效果

在知识库中,许多内容以分段形式存储,这可能会影响检索的准确性。针对这一问题,可以采取以下优化措施:

- 提高语义分割的精度:

通过调整文档解析模型的“Text Splitting”参数,将长段落切分为更小的语义单元,从而提高检索的相关性。

- 增强嵌入模型的训练:

使用更大的训练数据集优化嵌入模型,使其能够更好地理解分段式内容的上下文关系。

- 增加上下文扩展:

在检索结果中包含更多上下文信息,以便系统能够更准确地回答复杂问题。

通过以上优化措施,可以显著提升分段式内容的检索能力,使系统能够支持更复杂的查询场景。

对比不同工具的问答精准度

为了评估系统在实际应用中的表现,可以与其他工具进行问答精准度的对比。例如,使用Deepseek的官方对话系统与本地部署的RAG工作流进行测试,观察两者在同一问题上的响应。

- 在Deepseek官方对话系统中输入问题:“找一下iOS禁止系统更新的网址”,发现其无法准确找到相关内容。

- 在本地RAG系统中测试,系统可以精准地返回知识库中的网址,并保持内容的完整性。

- 对于分段式问题,Deepseek系统可能会出现信息遗漏,而本地系统在提供提示后可以进一步优化答案的准确性。

通过对比测试,可以发现本地部署的RAG系统在精准性和效率上具有显著优势,同时也为进一步优化提供了参考方向。

综上所述,测试知识库的准确性不仅是验证系统性能的关键,还能帮助识别优化点并提升用户体验。在实际应用中,通过不断调整和测试,可以构建一个更高效、更精准的知识库检索系统。

Ollama常用命令大全

Ollama是一款功能强大的工具,用于管理本地AI模型。通过掌握常用命令,用户可以高效地完成模型下载、上下文清理、模型信息查看、删除操作等任务,同时学习如何启动服务器和创建模型文件。以下是对Ollama常用命令的详细说明。

模型管理:下载、清除上下文、查看信息与删除

Ollama提供了一系列用于模型管理的命令,以下是主要功能及其使用方法:

- 模型下载:

运行以下命令即可下载指定的模型:

ollama run <模型名字>例如:

ollama run hf.co/Qwen/Qwen3-Embedding-4B-GGUF:Q4_K_M,此命令会从指定的模型源下载模型到本地。 - 清除上下文:

在对话过程中,可以使用命令清除当前的上下文数据:

/clear此命令适用于需要重新开始对话或清理临时数据的场景。

- 查看模型信息:

使用以下命令查看当前本地模型的信息:

ollama show <模型名字>该命令会返回模型的详细信息,包括名称、版本、大小等。

- 删除模型:

如果需要移除某个模型,可以运行以下命令:

ollama rm <模型名字>在删除前请确保模型不再被使用,以免影响工作流。

启动Ollama服务器

为了使模型能够被外部工具调用或进行测试,需要启动Ollama服务器。以下是启动方法:

- 运行以下命令启动服务器:

ollama serve服务器的启动使模型具备对外服务能力,是集成到工作流中的重要一步。

创建模型文件的步骤和命令

Ollama支持用户通过自定义模型文件创建嵌入模型,这为特殊需求提供了极大的灵活性。

- 创建模型文件:

首先创建一个简单的模型文件(Modelfile),指定模型路径:

echo FROM <模型路径> > Modelfile例如:

echo FROM E:\Ollama\Qwen3-Embedding-4B-Q4_K_M.gguf > Modelfile。 - 生成嵌入模型:

使用以下命令创建一个新的嵌入模型:

ollama create <模型名字> -f Modelfile例如:

ollama create qwen3_embedding -f Modelfile。 - 验证模型:

创建完成后,可以通过API测试模型是否正常工作。

通过以上命令,用户可以灵活管理模型,快速启动服务,并根据需求创建自定义嵌入模型,为系统运行提供强大的支持。