一、什么是 MCP

MCP(Model Context Protocol)是一个专为大型语言模型(LLM)设计的开放协议,旨在通过统一的标准实现信息的高效交互。它的核心理念是让LLM能够与外部资源、工具和服务无缝连接,从而扩展模型的能力边界。以下将详细介绍MCP的定义、功能和价值。

MCP的定义:作为一种协议标准,MCP的名称分别代表了以下三个核心概念:

- Model: 表示服务主体是大型语言模型(LLM),它是整个协议的核心。

- Context: 强调了其作为信息枢纽的功能,可以整合多种来源的信息。

- Protocol: 表明这是一个标准化的信息交互框架,可以确保连接的统一性和高效性。

通过这种设计,MCP能够让LLM在完成训练后继续突破固有的能力限制,成为一个可以动态适应多种场景的智能系统。

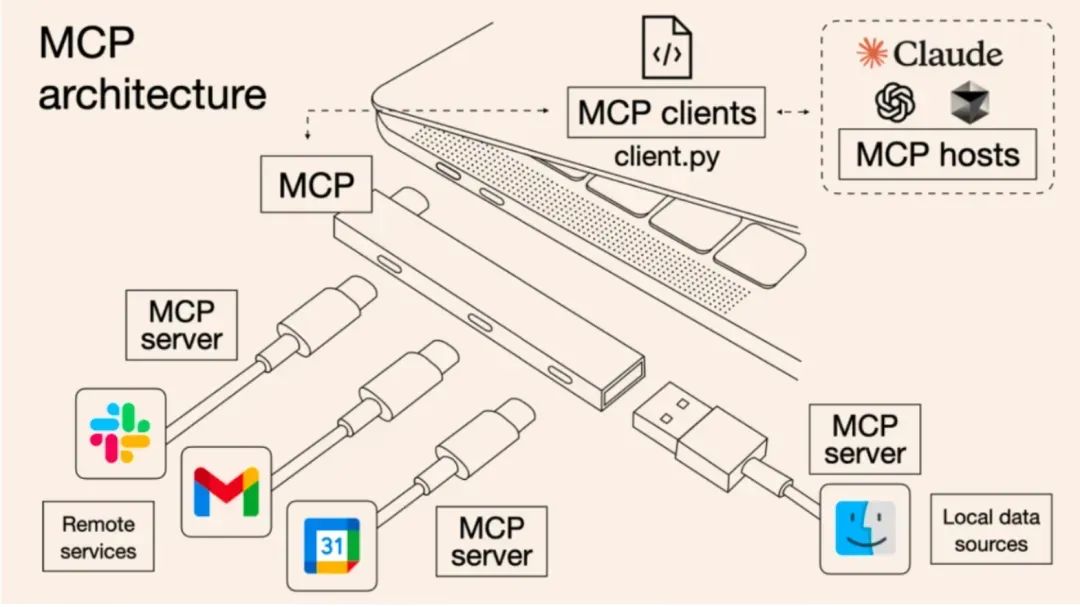

功能类比USB-C接口:可以将MCP的功能类比为计算机领域的USB-C接口。USB-C通过统一的标准支持多种设备的连接,而MCP则通过协议标准化的方式,让LLM能够无缝接入多种外部资源。例如,通过MCP,LLM不仅可以调用本地数据(如磁盘存储),还可以连接远程服务(如邮件服务器或天气数据接口)。这种类似“万能适配器”的设计,让LLM能够在各种场景中灵活运作。

突破LLM能力边界:在传统的使用场景中,LLM的能力通常受到训练数据的限制。例如,模型可能无法直接回答实时性问题(如“明天的天气如何”)。但通过MCP协议,LLM可以连接到实时数据源或动态工具,从而突破这些限制。例如,MCP可以让LLM接入气象数据接口,使其能够回答关于天气的即时性问题。这种能力扩展不仅提升了LLM的实用性,也为智能体的开发提供了更大的想象空间。

总之,MCP通过其标准化协议,成功将大型语言模型与多种外部资源连接起来,赋予模型更强大的能力和灵活性。这种设计不仅增强了LLM的实用性,也为智能体的未来发展提供了坚实的技术基础。

二、MCP的组成

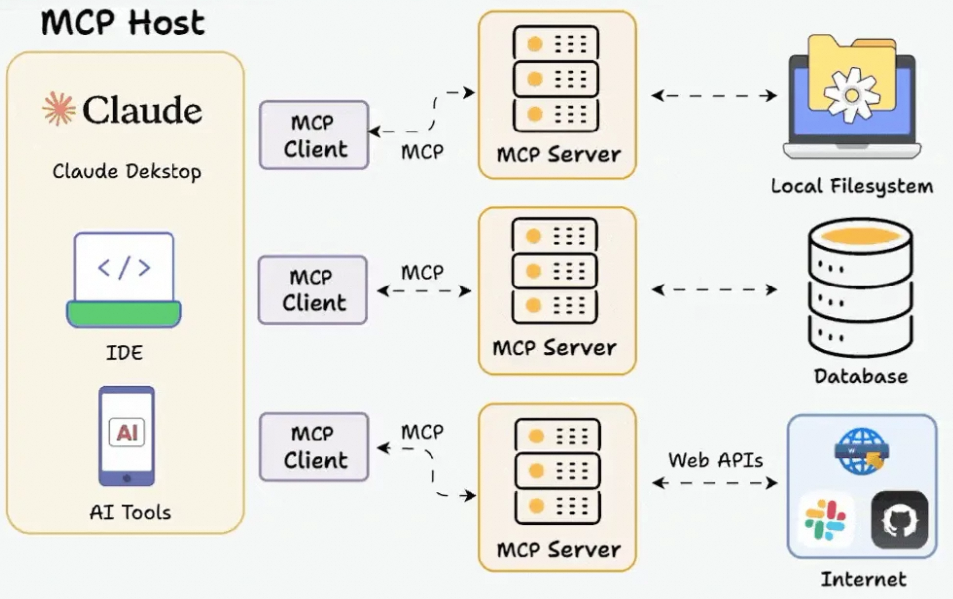

MCP(Model Context Protocol)采用经典的客户端-服务器架构,通过标准化协议有效地连接大型语言模型(LLM)与外部资源。它的设计简洁而高效,核心组成部分包括MCP Host、MCP Client和MCP Server。以下将详细介绍每个部分的功能及其在整个体系中的角色。

1. MCP Host:

MCP Host是协议中的外部能力集成主体,可以看作是用户与模型之间的桥梁。它通常表现为图形界面工具或生产力应用,例如集成开发环境(IDE)或基于LLM构建的生产力工具。MCP Host的主要职责是:

- 充当用户交互的主要界面,让用户可以通过友好的方式利用LLM的能力。

- 协调用户请求与LLM及外部资源之间的交互,确保整个过程顺畅且无缝。

- 为LLM扩展提供运行环境,例如注册额外的工具或服务。

举个例子,像VS Code这样的IDE可以作为MCP Host,它通过集成特定的MCP Server,使得LLM可以执行诸如代码建议、语法检查等复杂任务。

2. MCP Client:

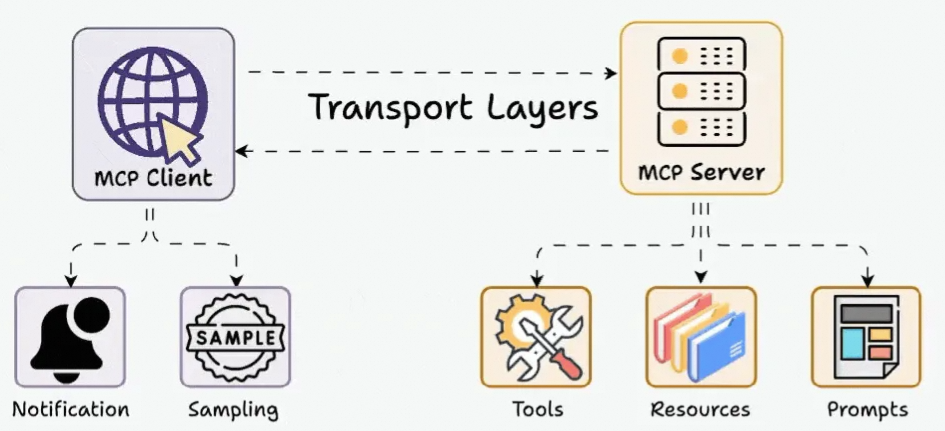

MCP Client是协议中负责与MCP Server交互的中间组件。它由MCP Host创建并运行,承担协议翻译和消息处理的角色。具体来说,MCP Client的功能包括:

- 接收来自MCP Host的请求,并将这些请求转化为符合MCP标准的消息格式。

- 与MCP Server建立一对一的有状态会话,确保消息流的安全性和完整性。

- 解析来自MCP Server的响应,并将其转换为Host能够理解的格式,最终返回给用户。

通过MCP Client的设计,协议的复杂性被隐藏在底层,用户可以专注于任务本身,而无需关注具体的技术细节。

3. MCP Server:

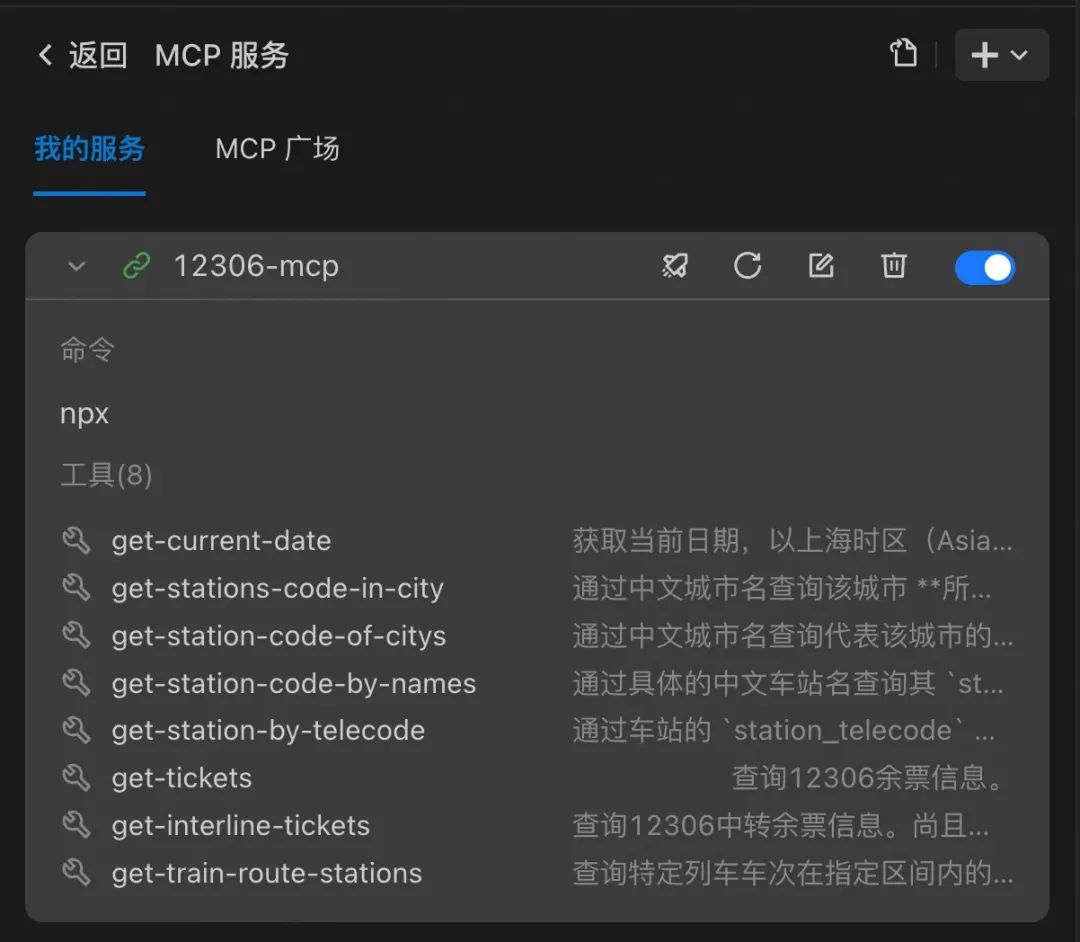

MCP Server是整个架构中最重要的部分之一,它负责将外部能力通过标准协议暴露给LLM。这些能力通常分为以下三类:

- Resources(资源): MCP Server可以提供静态或半动态的数据资源,比如日志文件、配置文件或数据库内容。这些资源能够直接被LLM理解并用于推理。

- Tools(工具): MCP Server可以定义一系列工具,用于执行具体任务,例如查询天气、调用API或写入数据库。这些工具通常具有相关性,描述了Server所具备的所有功能。

- Prompts(提示模板): 提供预定义的语言模型提示模板,用于优化LLM处理特定任务的表现,例如调整输入输出格式或加入特化逻辑。

例如,当用户询问“帮我查询明天从上海到北京的最快车次”,MCP Server可以通过查询数据库和API,提供实时的车次信息,并将结果反馈给LLM。

总的来说,MCP的三大组成部分通过清晰的分工与协作,构建了一个高效、灵活的架构。它不仅让LLM能够扩展到更多场景,还降低了开发者的接入成本,推动了智能体技术的标准化和广泛应用。

三、MCP的意义

MCP(Model Context Protocol)的出现为大型语言模型(LLM)的应用和开发带来了革命性的改变。它不仅简化了智能体与外部资源的连接方式,还为开发者和企业提供了一个高效且低成本的解决方案。以下将从降低开发门槛、提升开发效率以及推动生产力应用的角度,详细阐述MCP的意义。

1. 通过统一协议实现低成本接入:

传统上,开发者在为LLM扩展功能时,需要针对不同的工具和资源编写大量的自定义代码。这种方式不仅耗费时间,还可能因为接口不统一而导致兼容性问题。而MCP通过统一的协议标准,解决了这一痛点。

- MCP使用标准化的通信方式,让开发者可以轻松将外部资源接入LLM,无需重新设计复杂的接口。

- 这种低成本的接入方式降低了技术门槛,使得更多团队和个人能够参与智能体的开发浪潮。

- 同时,它减少了重复劳动,避免了不同工具之间的适配难题,显著提升了开发效率。

对于企业而言,MCP的低成本特性意味着可以更快、更经济地将LLM应用于实际业务场景,从而实现更高的投资回报率。

2. 提供标准化方式,提升开发效率:

在模型功能扩展领域,Function Calling曾被认为是一个重要的技术突破。然而,这种方法的限制在于各供应商的实现方式不同,导致开发者需要针对不同的模型重复开发和调试。相比之下,MCP作为一种开放协议,提供了标准化的解决方案。

- MCP的统一协议让开发者只需一次性实现对接代码,就能与多种工具和资源无缝连接。

- 通过标准化,MCP消除了因不同实现方式而产生的调试和优化成本。

- 此外,MCP的设计还支持灵活扩展,开发者可以轻松添加新的功能模块,而无需重构现有系统。

这种标准化的方式不仅帮助开发者节约了时间和精力,还为整个行业的协作奠定了基础,进一步推动了智能体技术的成熟。

3. 为LLM提供更多业务理解,推动通用生产力的实现:

LLM的真正价值在于其强大的理解和处理能力,但其应用范围仍然受到数据和功能的限制。MCP的出现改变了这一现状,它为LLM注入了业务理解,进一步拓展了模型的能力边界。

- 通过MCP,LLM可以接入企业的专属数据、工具和工作流,从而直接参与生产力任务,例如财务分析、客户服务或供应链优化。

- 这种能力的扩展让智能体不仅能“聊天”,还能“干活”,真正实现从辅助工具到生产力核心的转变。

- 此外,MCP还支持动态的功能拓展,例如通过接入实时数据源,让LLM能够进行即时性的分析和决策,为企业提供了更大的灵活性。

最终,MCP通过提升LLM的业务理解能力,帮助企业和开发者实现了智能化转型。这不仅提高了工作效率,还推动了通用生产力的广泛应用,让智能体技术成为各行业的重要工具。

综上所述,MCP的意义在于其对智能体技术的全面推动。它通过降低开发门槛和成本,标准化开发流程,以及扩展LLM的应用场景,让智能体技术不仅成为技术创新的驱动力,也成为各行业生产力飞跃的关键助力。

四、如何系统学习掌握AI大模型

随着人工智能技术的快速发展,AI大模型已经成为推动技术创新和产业升级的重要工具。要想系统掌握AI大模型,需要从基础知识到高级技能逐步深入,同时结合丰富的学习资源和实践经验。以下是具体的学习建议和资源推荐。

1. 从基础知识到实战技能,逐步深入:

学习AI大模型需要一个循序渐进的过程,涵盖基础理论到实战技能的全面掌握:

- 从基础理论开始,例如深度学习的基本概念、神经网络的工作原理,以及如何通过训练数据让模型学习。

- 逐步深入到大模型的核心技术,如Transformer架构、注意力机制和预训练技术。这些是大模型的核心驱动因素。

- 通过小型项目和案例实践,提升对大模型应用场景的理解,例如文本生成、图像识别和推荐系统等。

在学习过程中,搭建自己的实验环境(如使用Python和开源框架如TensorFlow或PyTorch)可以帮助加深对技术的理解。

2. 推荐学习资源:

为了系统地学习AI大模型,以下几类资源可以帮助学习者全面提升:

- 成长路线图:一份详细的学习路线图可以帮助新手快速入门,并为高级学习者提供提升路径。路线图通常包含知识点的层次划分以及学习目标。

- 经典PDF书籍:领域内的权威书籍和技术手册是构建理论基础的重要工具。例如《Deep Learning》是深度学习领域的经典参考书。

- 视频教程:对于初学者来说,视频教程可以通过动态演示帮助理解复杂概念,例如课程平台上的机器学习和大模型实战课程。

- 实战项目:参与实际项目是检验知识的最佳方式,例如构建一个基于GPT的大模型应用,或实现一个文本分类的任务。

这些资源的结合可以帮助学习者从理论到实践全面提升,为未来的职业发展打下坚实基础。

3. 面试题库助力职业发展:

掌握AI大模型不仅仅是技术学习,还需要面对职业发展的挑战。面试题库是为职场准备的重要工具:

- 通过经典面试题了解行业需求,例如模型优化、算法设计和实际应用场景的解决方案。

- 练习实际问题解决能力,模拟面试场景,提升对技术问题的表达能力和逻辑分析能力。

- 了解行业内最新趋势,例如大模型如何与云计算结合,或者在生产环境中如何部署大模型。

通过面试题库的学习,学习者可以更好地将理论知识与实践结合,并增强面对技术挑战的信心。

总之,系统学习AI大模型需要从理论到实践的全面提升,同时利用丰富的学习资源和工具。通过不断深入学习和实践,不仅可以掌握这项技术,还能够为职业发展开辟新的机遇。